Danke für Ihr Interesse an den Lernpräferenzen!

Danke für dein Interesse an verschiedenen Lernmethoden! Welche Methode bevorzugst du? (z. B. „Audio“, „Video“, „Text“, „Keine Präferenz“) (optional)

Feedback sendenEinführung in Datenanalysenmethoden

Datenanalysenmethoden sind unerlässlich, um komplexe Datenmengen zu verstehen und fundierte Entscheidungen in der Informationstechnologie (IT) zu treffen. Diese Methoden helfen Dir, Daten zu sammeln, zu verarbeiten und daraus wertvolle Erkenntnisse abzuleiten.

Bedeutung von Datenanalysenmethoden in IT Bildung

In der technologischen Bildung bietet das Lernen von Datenanalysenmethoden wesentliche Vorteile:

- Verständnis der Daten: Du lernst, Daten zu interpretieren und die zugrunde liegenden Muster zu erkennen. Dies ist entscheidend in einer Welt, in der Daten in fast allen Bereichen genutzt werden.

- Problemlösungsfähigkeiten: Durch die Analyse von Daten können Probleme identifiziert und Lösungen entwickelt werden, die in der realen Welt von Bedeutung sind.

- Übertragung auf praktisch alle Branchen: Datenanalysenmethoden sind nicht nur auf die IT beschränkt. Kenntnisse in diesem Bereich können auf Felder wie Finanzen, Gesundheitswesen und Marketing übertragen werden.

'\begin{array}{|c|c|}\hline\text{Fähigkeit} & \text{Nutzen} \hline\text{Kritisches Denken} & \text{Bessere Entscheidungsfindung} \text{Datenverständnis} & \text{Erkennung von Mustern und Trends} \hline\end{array}' In der IT-Bildung spielen Datenanalysenmethoden auch bei der Entwicklung von Künstlicher Intelligenz und maschinellem Lernen eine wesentliche Rolle.

Anwendung von Datenanalysenmethoden in IT

Datenanalysenmethoden sind in der IT essentiell für diverse Anwendungsbereiche:

- Vorhersagemodelle: Durch statistische Analysen können Vorhersagemodelle entwickelt werden, die zukünftige Trends und Verhaltensweisen prognostizieren. Ein einfaches Beispiel dafür ist eine E-Commerce-Plattform, die Kundenverhalten analysiert, um Produktempfehlungen zu liefern.

- Fehlererkennung: Mithilfe von Analysetools können Anomalien oder Fehler in IT-Systemen frühzeitig erkannt und behoben werden. Dies unterstützt die IT-Abteilungen bei der Wartung und Verbesserung der Systemstabilität.

- Optimierung der Ressourcenverwendung: Durch die Auswertung von Daten zu Ressourcenverbrauch können IT-Infrastrukturen effizienter gestaltet und betrieben werden.

Ein besonders interessanter Bereich der Datenanalysenmethoden in der IT ist das Maschinelle Lernen. Hierbei handelt es sich um eine Methode der Datenanalyse, bei der Algorithmen eingesetzt werden, die aus vorhandenen Datenbeständen lernen und so Vorhersagen oder Entscheidungen treffen können. Mathematisch betrachtet geht es dabei oft um Optimierungsprobleme, die mit Hilfe von Statistik und linearer Algebra gelöst werden. Eine häufig genutzte Formel zur Beschreibung solcher Probleme lautet:

Statistische Methoden in der IT Ausbildung

Die Anwendung statistischer Methoden in der IT-Ausbildung ist essentiell, um tiefere Einblicke in Daten zu gewinnen und fundierte Entscheidungen zu treffen. Sie stellen die Werkzeuge zur Verfügung, um große Datenmengen effizient und präzise zu analysieren.

Grundlagen der statistischen Methoden in IT

Statistische Methoden in der IT umfassen eine Vielzahl von Techniken, die es ermöglichen, Informationen aus Daten zu extrahieren:

- Deskriptive Statistik: Beschreibt grundlegende Eigenschaften der Daten durch Maße wie Durchschnitt, Median und Standardabweichung. Zum Beispiel kann der Durchschnitt der Antwortzeiten eines Servers helfen, dessen Performance einzuschätzen.

- Inferentielle Statistik: Ermöglicht das Ziehen von Schlussfolgerungen über eine Population basierend auf einer Stichprobe. Eine Anwendung ist das Testen von Hypothesen, z.B. ob eine neue Software-Version schneller ist als die alte Version.

Mathematisch gesehen umfasst die deskriptive Statistik Formeln wie:

Die Standardabweichung kann folgendermaßen berechnet werden:

Deskriptive Statistik bezieht sich auf Methoden zur Zusammenfassung und Visualisierung von Daten. Wesentliche Aspekte sind Mittelwert, Median und Modus.

'\begin{array}{|c|c|}\hline\text{Stichprobe} & \text{Mittelwert} \hline\text{Server A} & 200 \text{Server B} & 250 \hline\end{array}' Deskriptive Statistik ist oft der erste Schritt bei der Datenanalyse und legt die Grundlage für weiterführende statistische Tests.

Statistische Techniken zur Datenanalyse

Zur Datenanalyse in der IT kommen verschiedene statistische Techniken zum Einsatz:

- Regressionsanalyse: Hilft, Beziehungen zwischen Variablen zu modellieren und vorherzusagen. Ein häufig verwendetes Modell ist die lineare Regression, beschrieben durch:

- Cluster Analyse: Gruppiert ähnliche Datenpunkte, was in der IT oft zur Identifizierung von Benutzergruppen oder zur Segmentierung von Netzwerken verwendet wird.

- Varianzanalyse (ANOVA): Testet, ob es signifikante Unterschiede zwischen den Mittelwerten von mehr als zwei Gruppen gibt.

Im praktischen Einsatz kann Python zur Umsetzung dieser Techniken genutzt werden:

'import numpy as np''from sklearn.linear_model import LinearRegression''# Beispiel für lineare Regression''X = np.array([[1, 1], [1, 2], [2, 2], [2, 3]])''y = np.dot(X, np.array([1, 2])) + 3''reg = LinearRegression().fit(X, y)'

Ein tieferer Blick auf die Regressionsanalyse zeigt, dass es nicht nur um das Anpassen eines Modells an die Daten geht. Es geht auch darum, die Güte des Modells zu bewerten und Vorhersagen zu treffen. Dabei spielt

Hierbei ist

Durchführung von Datenanalysen

Die Durchführung von Datenanalysen ist ein systematischer Prozess, der es ermöglicht, wertvolle Informationen aus Datenbeständen zu extrahieren. Dabei werden verschiedene Schritte und Werkzeuge eingesetzt, um präzise Ergebnisse zu erzielen.

Schritte bei der Durchführung von Datenanalysen

Bei der Durchführung von Datenanalysen werden typischerweise folgende Schritte befolgt:

- Datensammlung: Zuerst müssen die relevanten Daten gesammelt werden. Dies kann durch Datenbanken, APIs oder manuelle Eingaben erfolgen.

- Datenaufbereitung: Die gesammelten Daten werden bereinigt und in ein nutzbares Format gebracht. Dies umfasst das Entfernen von Duplikaten und das Füllen fehlender Werte.

- Datenexploration: In diesem Schritt werden grundlegende Eigenschaften der Daten untersucht, oft mittels deskriptiver Statistiken und Visualisierungen.

- Modellbildung: Ein Modell wird entwickelt, um Beziehungen in den Daten zu erkennen. Häufig genutzte Methoden sind Regressionsanalysen oder maschinelle Lernalgorithmen.

- Ergebnisinterpretation: Die Ergebnisse werden interpretiert und auf ihre Anwendbarkeit hin überprüft.

- Berichterstattung: Schlussendlich werden die Ergebnisse dokumentiert und präsentiert, oft in Form von Berichten oder Dashboard-Visualisierungen.

Die Datenaufbereitung ist ein entscheidender Schritt, der sicherstellt, dass die Daten sauber und in einem geeigneten Format sind, bevor komplexe Analysen durchgeführt werden.

Angenommen, Du arbeitest mit einem Datensatz, der die Verkaufszahlen eines Unternehmens enthält. Zuerst bereinigst Du die Daten, indem Du fehlende Umsatzzahlen mit dem Durchschnittswert füllst:

'\[\text{Durchschnitt} = \frac{1}{n} \sum_{i=1}^{n} x_i\]' Hierbei verwendest du den Durchschnitt zur Schätzung fehlender Werte, um Verzerrungen in nachfolgenden Analysen zu vermeiden.

Datenexploration ist besonders faszinierend, da sie Dir ermöglicht, erste Einsichten zu gewinnen, die oft unerwartet sind. Diese Phase kann potenzielle Ausreißer identifizieren, die den Analyseprozess stören könnten. Eine der Techniken hierfür ist die Anwendung von Boxplots, die helfen, die Verteilung der Daten genauso wie potenzielle Ausreißer grafisch darzustellen. Mathematisch sind Boxplots durch fünf Kennzahlen definiert: Minimum, erster Quartil (

'\[\text{IQR} = Q3 - Q1\]' Dies hilft, den Verteilungsumfang der zentralen 50% der Daten zu verstehen. Ein weiterer spannender Aspekt ist die Mustererkennung, die durch Machine-Learning-Algorithmen realisiert werden kann, wie z.B. Clustering-Verfahren, die Datenpunkte anhand ihrer Ähnlichkeiten gruppieren und somit neue Erkenntnisse ermöglichen.

Werkzeuge für erfolgreiche Datenanalysen

Es gibt eine Vielzahl von Werkzeugen, die bei der Durchführung von Datenanalysen eingesetzt werden:

- Programmiersprachen wie Python und R: Diese werden häufig für Datenanalyseaufgaben genutzt, da sie leistungsstarke Bibliotheken wie Pandas, NumPy, und ggplot2 bieten.

- Datenbanken: Systeme wie SQL-Server oder NoSQL-Lösungen wie MongoDB helfen, große Datenmengen effizient zu speichern und abzurufen.

- Visualisierungstools: Werkzeuge wie Tableau oder Power BI ermöglichen es, Daten visuell darzustellen und die Analyseergebnisse anschaulich zu präsentieren.

- Cloud-Plattformen: Dienste wie AWS und Google Cloud bieten skalierbare Rechenressourcen und Werkzeuge für große Datenanalysen.

Für Anfänger im Bereich Datenanalyse wird häufig empfohlen, mit Python zu starten, da es eine große Online-Community und zahlreiche Ressourcen für alle Erfahrungsstufen gibt.

Beispiele für Datenanalysenmethoden

Datenanalysenmethoden bieten eine Vielzahl von Anwendungen, um aus großen und komplexen Datenmengen wertvolle Informationen abzuleiten. Die Wahl der richtigen Methode hängt stark von der Art der Daten und den gewünschten Ergebnissen ab.

Praxisbeispiele zur Anwendung von Datenanalysen

In der Praxis werden Datenanalysenmethoden in verschiedenen Bereichen eingesetzt, um effiziente und effektive Lösungen zu finden.

- Sentiment-Analyse: Diese Methode wird häufig im Bereich des Online-Marketings verwendet, um Kundenfeedback zu analysieren und die allgemeine Stimmung zu verstehen. Zu den Techniken gehören die Nutzung von Natural Language Processing (NLP) und maschinellem Lernen.

- Churn-Vorhersage: Unternehmen nutzen predictive analytics, um vorherzusagen, wann und warum Kunden abwandern könnten. Dies verbessert die Kundenbindung und senkt die Abwanderungsquote.

- Zustandsüberwachung: In der Fertigung werden Sensordaten analysiert, um frühzeitig auf abweichende Maschinenleistungen zu reagieren und Ausfälle zu minimieren.

Mathematisch können solche Vorhersagen oft durch Regressionsmodelle beschrieben werden:

Hierbei stellt

Stelle Dir vor, ein Online-Shop analysiert Kundenbewertungen, um die Kundenzufriedenheit zu messen. Dazu wird ein sentimentales Analysemodell eingesetzt, das Kundenrezensionen in positive, neutrale oder negative Stimmung einteilt:

'{\ 'review': 'Das Produkt ist ausgezeichnet!',\ 'sentiment': 'positive'\ }' Der Einsatz von Datenanalysen kann die strategische Entscheidungsfindung in Unternehmen erheblich verbessern.

Fallstudien zu Datenanalysen in IT

Datenanalysen in der IT bieten zahlreiche Möglichkeiten, Geschäftsprozesse zu optimieren und Mehrwert zu erzielen. Hier sind einige Fallstudien zur Verdeutlichung:

- E-Commerce Optimierung: Ein führendes E-Commerce-Unternehmen setzte Datenanalysen ein, um sein Checkout-System zu optimieren. Durch A/B-Tests und die Analyse von Kundenverhalten konnte die Konversionsrate signifikant gesteigert werden.

- Betrugserkennung: Ein Finanzdienstleister implementierte maschinelle Lernalgorithmen, um betrügerische Transaktionen in Echtzeit zu identifizieren und zu blockieren. Die Anwendung solcher Techniken führte zu einer Reduktion der Betrugsfälle um 30%.

- IT-Support-Analyse: Ein großes Technologieunternehmen verwendete Datenanalysen, um häufige Probleme im technischen Support zu identifizieren und automatisierte Lösungen bereitzustellen. Dies reduzierte die Support-Zeit und verbesserte die Kundenzufriedenheit.

Zur Visualisierung der Ergebnisse wurden häufig Tools wie Tableau eingesetzt, die es ermöglichen, komplexe Datenmuster anschaulich darzustellen.

Ein bemerkenswerter Aspekt in der Betrugserkennung ist der Einsatz von neuronalen Netzwerken. Diese Netzwerke werden dafür trainiert, komplexe Muster und Anomalien in großen Datenmengen zu erkennen. Ein einfaches neuronales Netzwerk kann mathematisch durch die Aktivierungsfunktion aufgezeigt werden:

Hierbei repräsentieren

Datenanalysenmethoden - Das Wichtigste

- Datenanalysenmethoden: Techniken zur Sammlung, Verarbeitung und Analyse von Daten zur Ableitung von Erkenntnissen in IT.

- Bedeutung in IT Bildung: Stärkt Deine Problemlösungsfähigkeiten, Interpretationsfähigkeiten und hat branchenübergreifende Anwendung.

- Anwendung in IT: Nutzen der Methoden zur Erstellung von Vorhersagemodellen, Fehlererkennung und Ressourcenoptimierung.

- Statistische Methoden in IT Ausbildung: Deskriptive und inferentielle Statistik ermöglichen die Analyse großer Datenmengen zur Entscheidungsfindung.

- Durchführung von Datenanalysen: Ein Prozess mit Schritten wie Datensammlung, Aufbereitung, Exploration, Modellbildung, Interpretation und Berichterstattung.

- Beispiele für Datenanalysenmethoden: Anwendungen wie Sentiment-Analyse, Churn-Vorhersage und Zustandsüberwachung, um Trends und Benutzerverhalten zu verstehen.

Lerne schneller mit den 12 Karteikarten zu Datenanalysenmethoden

Melde dich kostenlos an, um Zugriff auf all unsere Karteikarten zu erhalten.

Häufig gestellte Fragen zum Thema Datenanalysenmethoden

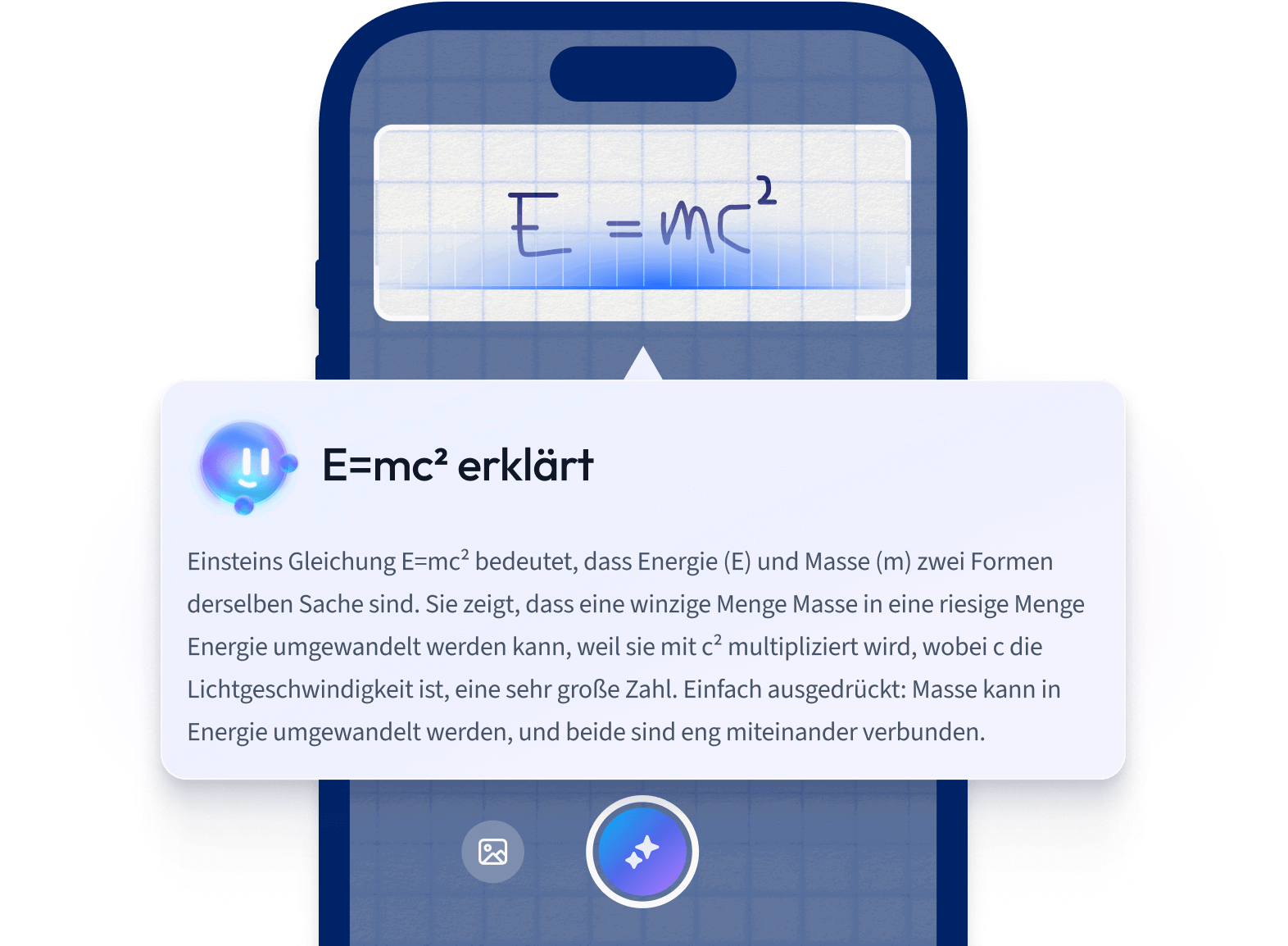

Über StudySmarter

StudySmarter ist ein weltweit anerkanntes Bildungstechnologie-Unternehmen, das eine ganzheitliche Lernplattform für Schüler und Studenten aller Altersstufen und Bildungsniveaus bietet. Unsere Plattform unterstützt das Lernen in einer breiten Palette von Fächern, einschließlich MINT, Sozialwissenschaften und Sprachen, und hilft den Schülern auch, weltweit verschiedene Tests und Prüfungen wie GCSE, A Level, SAT, ACT, Abitur und mehr erfolgreich zu meistern. Wir bieten eine umfangreiche Bibliothek von Lernmaterialien, einschließlich interaktiver Karteikarten, umfassender Lehrbuchlösungen und detaillierter Erklärungen. Die fortschrittliche Technologie und Werkzeuge, die wir zur Verfügung stellen, helfen Schülern, ihre eigenen Lernmaterialien zu erstellen. Die Inhalte von StudySmarter sind nicht nur von Experten geprüft, sondern werden auch regelmäßig aktualisiert, um Genauigkeit und Relevanz zu gewährleisten.

Erfahre mehr