Danke für Ihr Interesse an den Lernpräferenzen!

Danke für dein Interesse an verschiedenen Lernmethoden! Welche Methode bevorzugst du? (z. B. „Audio“, „Video“, „Text“, „Keine Präferenz“) (optional)

Feedback sendenGrundlagen der Datenbeschaffung

Die Datenbeschaffung bildet die Grundlage für viele Prozesse in der Informationstechnologie. Von der Datenerhebung bis zur Analyse ermöglichen richtige Daten richtungsweisende Entscheidungen und Innovationen.

Was ist Datenbeschaffung?

Datenbeschaffung bezeichnet den Prozess des Sammelns und Erfassens von Daten. Diese können aus unterschiedlichen Quellen stammen und in verschiedenen Formaten vorliegen. In der IT ist die Datenbeschaffung essentiell, um genaue Informationen über Nutzerverhalten, Markttrends oder Systemleistungen zu erhalten.

- Primärdaten: Diese Daten werden direkt von der Quelle erhoben. Beispiele sind Umfragen oder Sensoren.

- Sekundärdaten: Hierbei handelt es sich um bereits vorhandene Daten, die zu einem anderen Zweck gesammelt wurden.

Datenbeschaffung ist der Prozess, bei dem notwendige Daten gesammelt werden, um Informationssysteme effizient betreiben und Entscheidungen treffen zu können.

Ein Beispiel für Datenbeschaffung ist die Datenerhebung einer E-Commerce-Website, um Informationen über die meistverkauften Produkte oder die Kundenpräferenzen zu erhalten.

Bedeutung von Daten in der IT

Daten sind das Herzstück der modernen IT-Landschaft. Sie helfen Unternehmen, effektiver zu arbeiten, indem sie Einblicke in Prozesse gewähren und die Automatisierung von Aufgaben ermöglichen. Die Bedeutung von Daten in der IT liegt in mehreren Bereichen:

- Business Intelligence: Mithilfe von Daten können Unternehmen Marktanalysen durchführen und strategische Entscheidungen treffen.

- Kundenerfahrung: Durch die Analyse von Nutzerdaten können maßgeschneiderte Dienstleistungen angeboten werden.

- Systemoptimierung: Daten helfen, IT-Systeme effektiver zu gestalten und Engpässe zu identifizieren.

Daten sind nicht nur für große Unternehmen wichtig. Auch kleine Unternehmen und Start-ups können durch die richtige Nutzung von Daten einen Wettbewerbsvorteil erzielen.

Ein besonders spannender Bereich der Datenverarbeitung ist das maschinelle Lernen. Hierbei werden Algorithmen entwickelt und trainiert, um Muster in großen Datenmengen zu erkennen und Vorhersagen zu treffen. Dies erfordert umfangreiche Datenbeschaffung, um Modelle mit ausreichend Informationen zu versorgen.

Beispielsweise können Algorithmen zur Vorhersage von Wetterbedingungen eingesetzt werden, wofür riesige Mengen an Wetterdaten beschafft und analysiert werden müssen. Der Nutzen solcher Technologien zeigt sich in diversen Anwendungen von der Landwirtschaft bis hin zu komplexen Finanzmarktanalysen.

Typische Datenbeschaffungsmethoden

Es gibt verschiedene Methoden zur Datenbeschaffung, die je nach Anwendungsfall ausgewählt werden. Zu den gängigsten Methoden gehören:

- Umfragen und Fragebögen: Direkte Feedback-Methode, um Präferenzen und Meinungen zu sammeln.

- Beobachtung: Verhaltensdaten werden durch Beobachtung von Interaktionen gewonnen.

- Web-Scraping: Automatisierte Extraktion von Daten aus Webseiten, um große Datenmengen zu analysieren.

- Datenbanken: Nutzung bestehender Datenbanken, um relevante Informationen zu sammeln.

Ein Softwareunternehmen nutzt Web-Scraping, um Wettbewerberpreise von Online-Shops zu sammeln und darauf basierend Preisanpassungen durchzuführen.

Automatisierte Datenbeschaffung

Die automatisierte Datenbeschaffung hat die Art und Weise verändert, wie Daten in der IT gesammelt und analysiert werden. Sie ermöglicht es, große Datenmengen effizient zu erfassen und zu verarbeiten, was in vielen Bereichen der Industrie von unschätzbarem Wert ist.

Automatische und manuelle Techniken im Vergleich

Bei der Datenbeschaffung gibt es grundlegend zwei Ansätze: manuelle und automatische Techniken. Je nach Anforderung können sowohl manuelle Methoden als auch automatisierte Prozesse zum Einsatz kommen.

| Manuelle Techniken | Automatisierte Techniken |

| Direkte Dateneingabe | Web-Scraping |

| Beobachtung und Notizen | API-Integration |

| Umfragen und Interviews | Machine Learning |

- Effizienz: Automatisierte Techniken sind in der Regel schneller und weniger fehleranfällig.

- Genauigkeit: Manuelle Methoden bieten oft präzisere Daten, da menschliches Urteilsvermögen genutzt wird.

- Skalierbarkeit: Automatisierte Prozesse sind besser skalierbar und können große Mengen an Daten ohne zusätzliche personelle Ressourcen bewältigen.

Automatisierte Datenbeschaffung bezieht sich auf den Einsatz von Technologien, um Daten ohne oder mit minimalem menschlichen Eingriff zu sammeln und zu verarbeiten.

Ein Unternehmen setzt auf automatisierte Datenbeschaffung, indem es eine API verwendet, um in Echtzeit Finanzmarktdaten zu erhalten. Dies spart Zeit und gewährleistet, dass die neuesten Daten sofort verfügbar sind.

Ein faszinierender Aspekt der automatisierten Datenbeschaffung ist die Verwendung von künstlicher Intelligenz und maschinellem Lernen. Diese Technologien ermöglichen es, nicht nur Daten zu sammeln, sondern auch Muster und Vorhersagen zu erkennen, die sonst unentdeckt blieben.

Der Einsatz von Machine Learning zur Datenbeschaffung kann in verschiedenen Bereichen erfolgen, von der Bilderkennung bis zur Verarbeitung natürlicher Sprache. Ein System kann beispielsweise darin trainiert werden, Millionen von Bildern zu analysieren und somit neue Trends in sozialen Medien schnell zu erkennen.

Tools und Technologien zur Automatisierung

Zur Automatisierung der Datenbeschaffung stehen eine Vielzahl von Tools und Technologien zur Verfügung. Diese sind darauf ausgelegt, Prozesse einfacher, schneller und zuverlässiger zu gestalten.

- Web-Scraping-Tools: Diese Software extrahiert Daten aus Webseiten und macht sie in einem strukturierten Format zugänglich. Beispiele sind BeautifulSoup und Scrapy.

- APIs: Application Programming Interfaces erlauben den Zugriff auf Datenbanken und Systeme, um Daten in Echtzeit auszutauschen. Sie sind besonders nützlich in Bereichen, in denen Echtzeitdaten benötigt werden.

- RPA (Robotic Process Automation): Diese Technologie nutzt Software, um wiederkehrende Aufgaben zu automatisieren. Ideal für Prozesse, die konsistente Eingaben erfordern.

Viele der heute genutzten Automatisierungstools sind Open-Source und bieten eine breite Community zur Unterstützung bei Implementierung und Anpassung.

Datenvorverarbeitung und ihre Rolle

In der Welt der IT spielt die Datenvorverarbeitung eine entscheidende Rolle. Sie ist der Prozess, der die Rohdaten in ein formatierbares und nützliches Format umwandelt. Ohne diese Vorverarbeitung könnten viele Systeme und Analysen nicht die benötigte Genauigkeit und Effizienz erreichen.

Warum ist Datenvorverarbeitung wichtig?

Die Datenvorverarbeitung ist essentiell, um sicherzustellen, dass die Informationen für die Analyse geeignet sind. Dabei wird nicht nur die Qualität der Daten verbessert, sondern auch die Effizienz der nachgelagerten Prozesse erhöht.

Einige der Gründe, warum die Datenvorverarbeitung wichtig ist, sind:

- Entfernung von Störungen: Unrelevante Daten und Ausreißer werden beseitigt, um die Analyse genauer zu gestalten.

- Datenintegration: Informationen aus verschiedenen Quellen werden kombiniert, um eine konsistente Datenbasis zu schaffen.

- Standardisierung: Die Daten werden in ein einheitliches Format gebracht, was die Nutzung vereinfacht.

- Mustererkennung: Verbesserte Daten ermöglichen es, Muster effektiver zu erkennen und Prognosen zu erstellen.

Ein einfaches Beispiel verdeutlicht dies: Bei der Analyse von Kundendaten wird während der Vorverarbeitung sichergestellt, dass alle Kundennamen in derselben Schreibweise vorliegen. Andernfalls könnte ein Kunde mehrfach erfasst werden und somit die Analyseergebnisse verfälschen.

Datenvorverarbeitung kann den Unterschied zwischen einer erfolgreichen und einer gescheiterten Datenanalyse ausmachen.

Ein komplexer Aspekt der Datenvorverarbeitung ist das Feature Engineering, das oft in maschinellen Lernprozessen eingesetzt wird. Dabei werden aus Rohdaten neue Merkmale generiert, die die Leistung des Modells verbessern können. Beispielsweise könnte aus einem Zeitstempel-Datensatz ein Merkmal wie 'Wochentag' extrahiert werden, um saisonale Muster besser zu erkennen.

Schritte in der Datenvorverarbeitung

Der Prozess der Datenvorverarbeitung umfasst mehrere wichtige Schritte, die sorgfältig durchgeführt werden müssen, um die Daten für die Analyse vorzubereiten:

- Datenbereinigung: Dabei werden fehlende Werte ersetzt, Dubletten entfernt und Inkonsistenzen beseitigt.

- Datenintegration: Informationen werden aus verschiedenen Quellen zusammengeführt, was eine kohärente Datenbasis schafft.

- Datenreduktion: Hierbei werden Daten verdichtet, um die Verarbeitung effizienter zu gestalten, ohne wesentliche Informationen zu verlieren.

- Datenumwandlung: Die Daten werden in das gewünschte Format oder die benötigte Einheit konvertiert. Beispielsweise könnte ein Datum von einem Textformat in ein numerisches Format umgewandelt werden.

Ein vereinfachtes Modell zur Datenbereinigung könnte in Python etwa folgendermaßen aussehen:

import pandas as pddf = pd.read_csv('data.csv')# Entfernen von Dublettendf.drop_duplicates(inplace=True)# Fehlende Werte auffüllendf.fillna(method='ffill', inplace=True)Mathematische Transformationen können ebenfalls eingesetzt werden, um die Daten in ein besser handhabbares Format zu konvertieren. Zum Beispiel kann die Log-Transformation zur Normalisierung von Daten genutzt werden:

Betrachte den numerischen DatensatzBig Data Datenbeschaffung

Big Data bezeichnet extrem große und komplexe Datensätze, die traditionelle Datenverarbeitungsanwendungen herausfordern. Die Datenbeschaffung für Big Data erfordert spezialisierte Techniken und Technologien, um diese Mengen effizient zu verwalten.

Mit der Datenmenge und -vielfalt von Big Data entstehen neue Möglichkeiten, aber auch Herausforderungen. Die richtige Beschaffung und Verwaltung dieser Daten ist entscheidend, um wertvolle Erkenntnisse zu gewinnen und die Systeme nutzbar zu halten.

Herausforderungen bei der Big Data Datenbeschaffung

Die Datenbeschaffung im Bereich Big Data ist mit zahlreichen Herausforderungen konfrontiert. Diese Herausforderungen müssen bewältigt werden, um die Vorteile von Big Data voll ausschöpfen zu können.

- Datenvolumen: Die Menge der Daten ist oft enorm, was speichertechnische und verarbeitungstechnische Probleme mit sich bringt.

- Datenvielfalt: Es gibt verschiedene Arten von Daten wie strukturierte, halbstrukturierte und unstrukturierte Daten, die aus verschiedenen Quellen stammen.

- Datenqualität: Sicherstellung, dass die gesammelten Daten genau und vertrauenswürdig sind.

- Datenintegrität: Überprüfung, dass Daten konsistent und aktuell bleiben.

- Sicherheitsaspekte: Gewährleistung, dass sensible Informationen geschützt werden.

Ein Beispiel für das Datenvolumen ist eine beliebte Social-Media-Plattform, die täglich Terabytes an Daten generiert und speichern muss.

Ein gutes Datenmanagementsystem ist unerlässlich, um die Herausforderungen bei der Big Data Datenbeschaffung zu meistern.

In der Big Data Welt spielt die Verteilte Verarbeitung eine entscheidende Rolle. Systeme wie Hadoop und Spark erlauben die Verarbeitung und Analyse von Daten über mehrere Maschinen hinweg. Diese verteilten Systeme nutzen das Map-Reduce-Paradigma, um große Datensätze in kleinere Segmente zu zerlegen, parallel zu verarbeiten und die Ergebnisse zu kombinieren.

Ein mathematisches Modell zur Erklärung des Map-Reduce-Paradigmas kann durch die Funktion

Methoden der Datenanalyse für Big Data

Die Datenanalyse im Bereich Big Data nutzt spezialisierte Techniken und Werkzeuge, um große Mengen an Daten zu analysieren und Erkenntnisse zu gewinnen. Zu den häufig verwendeten Methoden gehören:

- Predictive Analytics: Prognose künftiger Ereignisse anhand historischer Daten.

- Data Mining: Entdeckung von Mustern in großen Datensätzen.

- Machine Learning: Einsatz von Algorithmen, die aus Daten lernen und Vorhersagen treffen können.

- Sentiment Analysis: Analyse von Textdaten, um Meinungen oder Stimmungen zu erkennen.

- Stream Processing: Echtzeitanalyse von Datenströmen.

Ein Beispiel für Predictive Analytics ist die Analyse von Verbrauchertrends, um zukünftige Verkaufsprognosen zu erstellen.

Stell Dir vor, ein Einzelhandelsunternehmen nutzt eine Kombination aus Data Mining und Machine Learning, um Muster im Kaufverhalten seiner Kunden zu erkennen. Die Algorithmen entdecken, dass Kunden, die tendenziell Produkt A kaufen, in 70% der Fälle auch an Produkt B interessiert sind. Diese Erkenntnisse können genutzt werden, um maßgeschneiderte Promotionen und Empfehlungen zu erstellen.

Datenbeschaffung leicht erklärt

Die Welt der IT basiert auf der effizienten und genauen Datenbeschaffung. Der Prozess, bei dem Daten gesammelt, gefiltert und für die Nutzung in Systemen vorbereitet werden, ist entscheidend, um Informationswerte zu schaffen und technologische Entwicklungen zu fördern.

In der IT-Praxis spielt die Datenbeschaffung eine zentrale Rolle, sei es durch manuelle, halbautomatisierte oder vollautomatische Methoden.

Einfache Tools zur Datenbeschaffung für Einsteiger

Für Einsteiger gibt es zahlreiche Tools, die den Einstieg in die Datenbeschaffung erleichtern. Diese Tools sind einfach zu bedienen und bieten leistungsstarke Funktionen, um die Erfassung und Verarbeitung von Daten zu erleichtern.

- Microsoft Excel: Ein weit verbreitetes Tool, das Daten in Tabellenformat erfasst und einfache bis komplexe Berechnungen ermöglicht.

- Google Sheets: Ähnlich wie Excel, aber cloud-basiert und ideal für die Zusammenarbeit in Echtzeit.

- RapidMiner: Ein Tool für Datenanalyse und maschinelles Lernen, leicht verständlich für Anfänger.

- Orange: Eine Open-Source-Lösung für visuelle Programmierung und Datenanalyse.

Nehmen wir an, Du möchtest Nutzerdaten über eine einfache Online-Umfrage sammeln. Tools wie Google Forms ermöglichen es, Umfragen zu erstellen und die Antworten direkt in einem Google Sheet zu speichern, um eine einfache Analyse zu ermöglichen.

Ein spannendes Tool für die Datenbeschaffung ist Web-Scraping. Dies ist ein automatisiertes Vorgehen, mit dem Informationen von Webseiten gesammelt werden. Ein beliebtes Python-Modul dafür ist BeautifulSoup, das HTML-Dokumente parsen und Daten extrahieren kann.

from bs4 import BeautifulSoupimport requestsurl = 'https://example.com'response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')data = soup.find_all('h2')for item in data: print(item.text)Die oben gezeigte Python-Beispielanwendung lädt den HTML-Inhalt einer Webseite herunter und extrahiert alle Absatzüberschriften. Solche Techniken sind nützlich, um Daten aus verschiedenen Quellen systematisch zu sammeln.

Vor dem Durchführen von Web-Scraping ist es wichtig, die Nutzungsbedingungen der Ziel-Webseite zu überprüfen, um deren Richtlinien bezüglich automatisierter Datenabfragen einzuhalten.

Praktische Beispiele und Anwendungen der Datenbeschaffung

Datenbeschaffung findet in vielen realen Anwendungen Gebrauch. Unternehmen und Forschungseinrichtungen nutzen Daten auch dafür, um Erkenntnisse zu gewinnen und Entscheidungen zu treffen.

- Gesundheitswesen: Sammeln von Patientendaten für die Diagnose und Behandlung sowie die Verwaltung von Gesundheitsstatistiken.

- E-Commerce: Analyse von Käuferverhalten und Lagerbeständen, um Verkaufsstrategien zu optimieren.

- Finanzsektor: Erhebung von Markt- und Transaktionsdaten zur Risikobewertung und zur Erstellung von Finanzprognosen.

Ein Finanzanalyseunternehmen nutzt fortschrittliche Algorithmen zur Datenbeschaffung und -verarbeitung, um Echtzeit-Marktdaten zu analysieren. Dadurch kann das Unternehmen Trends und Anomalien auf dem Aktienmarkt schnell erkennen und entsprechend handeln.

In der wissenschaftlichen Forschung erleichtert die Datenbeschaffung die Entdeckung neuer Erkenntnisse. Zum Beispiel durch die Sammlung großer Datenmengen aus Teilchenbeschleuniger-Experimenten, die Physiker bei der Untersuchung der fundamentalen Eigenschaften der Materie unterstützen. Mit fortschrittlichen Methoden des Datenmanagements können Forscher riesige Mengen an experimentellen Daten verarbeiten und analysieren, um das Verständnis der physikalischen Gesetze des Universums zu vertiefen.

Datenbeschaffung - Das Wichtigste

- Datenbeschaffung: Der Prozess des Sammelns und Erfassens von Daten aus verschiedenen Quellen, essentiell für die IT und Entscheidungsfindung.

- Automatisierte Datenbeschaffung: Einsatz von Technologien, um Daten ohne oder mit minimalem menschlichen Eingriff zu sammeln, z.B. Web-Scraping und API-Integration.

- Datenvorverarbeitung: Umwandlung von Rohdaten in ein nützliches Format, zur Verbesserung der Datenqualität und Effizienz der Analyse.

- Big Data Datenbeschaffung: Umgang mit extrem großen und komplexen Datensätzen, der spezialisierte Techniken erfordert, z.B. verteilte Verarbeitung.

- Datenbeschaffung leicht erklärt: Praktische Einführung in manuelle und automatisierte Methoden der Datenerfassung, nützlich für Einsteiger.

- Techniken der Datenanalyse: Methoden zur Analyse großer Datenmengen, z.B. Predictive Analytics, Data Mining, und Machine Learning.

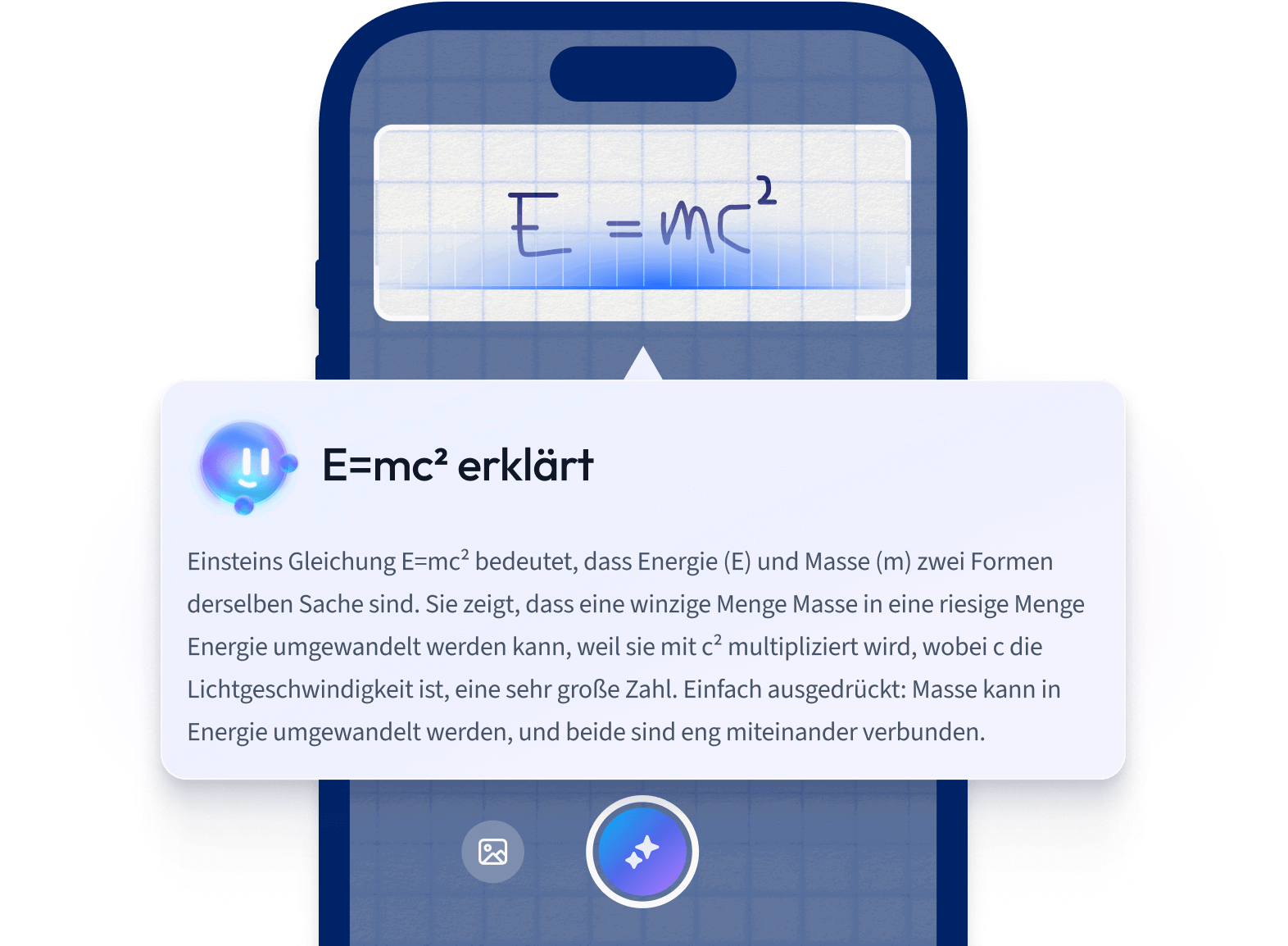

Lerne schneller mit den 10 Karteikarten zu Datenbeschaffung

Melde dich kostenlos an, um Zugriff auf all unsere Karteikarten zu erhalten.

Häufig gestellte Fragen zum Thema Datenbeschaffung

Über StudySmarter

StudySmarter ist ein weltweit anerkanntes Bildungstechnologie-Unternehmen, das eine ganzheitliche Lernplattform für Schüler und Studenten aller Altersstufen und Bildungsniveaus bietet. Unsere Plattform unterstützt das Lernen in einer breiten Palette von Fächern, einschließlich MINT, Sozialwissenschaften und Sprachen, und hilft den Schülern auch, weltweit verschiedene Tests und Prüfungen wie GCSE, A Level, SAT, ACT, Abitur und mehr erfolgreich zu meistern. Wir bieten eine umfangreiche Bibliothek von Lernmaterialien, einschließlich interaktiver Karteikarten, umfassender Lehrbuchlösungen und detaillierter Erklärungen. Die fortschrittliche Technologie und Werkzeuge, die wir zur Verfügung stellen, helfen Schülern, ihre eigenen Lernmaterialien zu erstellen. Die Inhalte von StudySmarter sind nicht nur von Experten geprüft, sondern werden auch regelmäßig aktualisiert, um Genauigkeit und Relevanz zu gewährleisten.

Erfahre mehr