Danke für Ihr Interesse an den Lernpräferenzen!

Danke für dein Interesse an verschiedenen Lernmethoden! Welche Methode bevorzugst du? (z. B. „Audio“, „Video“, „Text“, „Keine Präferenz“) (optional)

Feedback sendenRechenkomplexität Definition

Rechenkomplexität ist ein wesentliches Konzept in der Informatik. Sie bezieht sich darauf, wie viel Rechenressourcen - Zeit und Speicher - ein Algorithmus benötigt, um eine Berechnung durchzuführen. Dabei spielen die Anzahl der Operationen, die ein Computer ausführen muss, sowie der Speicher, den er dafür benötigt, eine zentrale Rolle. Das Verständnis der Rechenkomplexität ist entscheidend für die Entwicklung effizienter Programme, da es dabei hilft, Algorithmen zu wählen oder zu entwickeln, die mit minimalem Ressourcenverbrauch arbeiten.

Was ist Rechenkomplexität?

Rechenkomplexität beschreibt die erforderlichen Ressourcen eines Algorithmus in Bezug auf seine Eingabegröße. Dabei unterscheiden Informatiker zwischen verschiedenen Arten der Komplexität:

- Zeitkomplexität: Wie viel Zeit ein Algorithmus benötigt.

- Speicherkomplexität: Wie viel Speicherplatz ein Algorithmus benötigt.

Zeitkomplexität: Diese bezeichnet, wie viele elementare Operationen ein Algorithmus bezogen auf die Größe der Eingabe benötigt.

Speicherkomplexität: Diese misst den Speicherverbrauch eines Algorithmus in Abhängigkeit von der Größe der Eingabe.

Ein Beispiel: Wenn ein Algorithmus für eine Eingabemenge der Größe

Eine gute Faustregel: Je niedriger die Komplexitätsklasse, desto effizienter ist der Algorithmus. Strebe immer nach Algorithmen mit möglichst niedriger Komplexität.

Rechenkomplexität einfach erklärt

Um Rechenkomplexität zu verstehen, ist es wichtig, die Begriffe Zeitkomplexität und Speicherkomplexität zu kennen. Diese Begriffe helfen, die Effizienz von Algorithmen in Bezug auf die von ihnen benötigten Rechenressourcen zu bewerten. Eng damit verbunden ist die Frage, wie verschiedene Algorithmen miteinander verglichen werden können.

Grundlagen der Zeit- und Speicherkomplexität

Die Zeitkomplexität eines Algorithmus wird häufig mit der sogenannten Big-O-Notation beschrieben. Diese gibt an, wie die Ausführungszeit eines Algorithmus mit der Größe der Eingabedaten wächst. Die Speicherkomplexität wiederum beschreibt den Speicherbedarf eines Algorithmus, ebenfalls in Abhängigkeit von der Eingabegröße. Diese beiden Konzepte sind zentral für die Analyse und Optimierung von Algorithmen in der Informatik.

Die Big-O-Notation ist eine mathematische Notation, die verwendet wird, um die Wachstumsrate einer Funktion zu beschreiben. Sie hilft, die obere Grenze der Komplexität eines Algorithmus zu bestimmen.

Stelle dir vor, du hast einen Algorithmus, der die Summe aller Zahlen in einer Liste berechnet. Die Zeit, die dieser Algorithmus benötigt, variiert lineare je nach Anzahl der Zahlen. In Big-O-Notation ist dies

Bei der Analyse der Rechenkomplexität eines Algorithmus wird oft die durchschnittliche Fallanalyse verwendet. Diese Methode betrachtet die durchschnittliche Anzahl von Schritten, die für eine Vielzahl von Eingaben benötigt werden. Dies gibt eine genauere Einschätzung der Effizienz des Algorithmus in der Praxis.

| Notation | Bedeutung |

| O(1) | Konstant |

| O(n) | Linear |

| O(n^2) | Quadratisch |

| O(log n) | Logarithmisch |

| O(n log n) | Linearithmisch |

Es ist oft nützlich, den Speicher- und Zeitverbrauch eines Algorithmus parallel zu betrachten, um ein vollständiges Bild seiner Effizienz zu erlangen.

Rechenkomplexität Merge Sort

Der Merge Sort ist ein effizienter, stabiler Sortieralgorithmus, der auf dem Teile-und-herrsche-Prinzip basiert. Er teilt die zu sortierende Liste rekursiv in zwei Hälften, bis jede Liste nur noch ein Element enthält, und fügt diese dann in sortierter Reihenfolge wieder zusammen. Dies führt zu einer Zeitkomplexität von

Merge Sort ist ein effizientes, stabiles Sortierverfahren, dessen Komplexität in der Regel in

Angenommen, du musst die Liste

- Teile die Liste rekursiv:

- Sortiere die Teillisten:

- Füge sie zusammen:

Während der Merge Sort sehr effektiv ist, hat er auch eine Speicherkomplexität von

Der Merge Sort ist besonders nützlich, wenn eine stabile Sortierung erforderlich ist, da er die ursprüngliche Reihenfolge der gleichen Elemente beibehält.

Rechenkomplexität üben

Beim Üben der Rechenkomplexität ist es wichtig, die grundlegenden Konzepte zu verstehen und sie auf praktische Aufgaben anzuwenden. Die Fähigkeiten, Algorithmen hinsichtlich ihrer Effizienz zu beurteilen, sind für Informatiker essenziell.

Geringe Rechenkomplexität

Die niedrige Rechenkomplexität zeichnet sich durch Algorithmen aus, die wenig Ressourcen in Bezug auf Zeit und Speicher benötigen. Sie sind besonders wichtig in Umgebungen, in denen schnelle Berechnungen notwendig sind. Übliche Klassen für geringe Zeitkomplexität sind:

- O(1): Konstante Zeitkomplexität, unabhängig von der Eingabegröße

- O(log n): Logarithmische Zeitkomplexität, besonders bei binären Suchverfahren

O(1): Konstante Zeitkomplexität bedeutet, dass die Ausführungszeit immer gleich bleibt, unabhängig von der Eingabemenge.

Stell dir einen Algorithmus vor, der die erste Zahl in einer Liste zurückgibt. Egal wie groß die Liste ist, die Operation dauert immer genauso lange, was zu

Geringe Rechenkomplexität ist nicht nur ein Vorteil für die Geschwindigkeit; sie kann auch den Energieverbrauch von Computern reduzieren. In mobilen Geräten und eingebetteten Systemen, wo die Energieversorgung begrenzt ist, können Algorithmen mit niedriger Komplexität die Batterielaufzeit erheblich verlängern.

| Komplexität | Eigenschaft |

| O(1) | Unveränderlich |

| O(log n) | Skalierbar mit |

Vermeide es, bei Algorithmen mit hoher potenzieller Eingabemenge komplexere Komplexitätsklassen zu nutzen. Geringe Komplexität bleibt dein effizientester Ansatz.

Rechenkomplexität - Das Wichtigste

- Rechenkomplexität Definition: Bezieht sich auf die Ressourcen (Zeit und Speicher), die ein Algorithmus für die Bearbeitung von Eingabedaten benötigt.

- Zeitkomplexität und Speicherkomplexität: Unterscheidung zwischen der Zeit, die ein Algorithmus braucht, und dem Speicherplatz, den er benötigt, basierend auf der Eingabegröße.

- Typen der Zeitkomplexität: O(1) konstant, O(n) linear, O(n^2) quadratisch, O(log n) logarithmisch, O(n log n) linearithmisch.

- Rechenkomplexität Merge Sort: Ein stabiler Sortieralgorithmus mit einer Zeitkomplexität von O(n log n), der auf dem Teile-und-herrsche-Prinzip basiert.

- Geringe Rechenkomplexität: Algorithmen mit niedriger Zeit- und Speicherkomplexität (z.B. O(1), O(log n)), wichtig für schnelle Berechnungen und eingeschränkte Ressourcen.

- Rechenkomplexität anwenden: Wesentliches Verständnis notwendig, um Algorithmen effizient hinsichtlich ihrer Ressourcenanforderungen zu beurteilen.

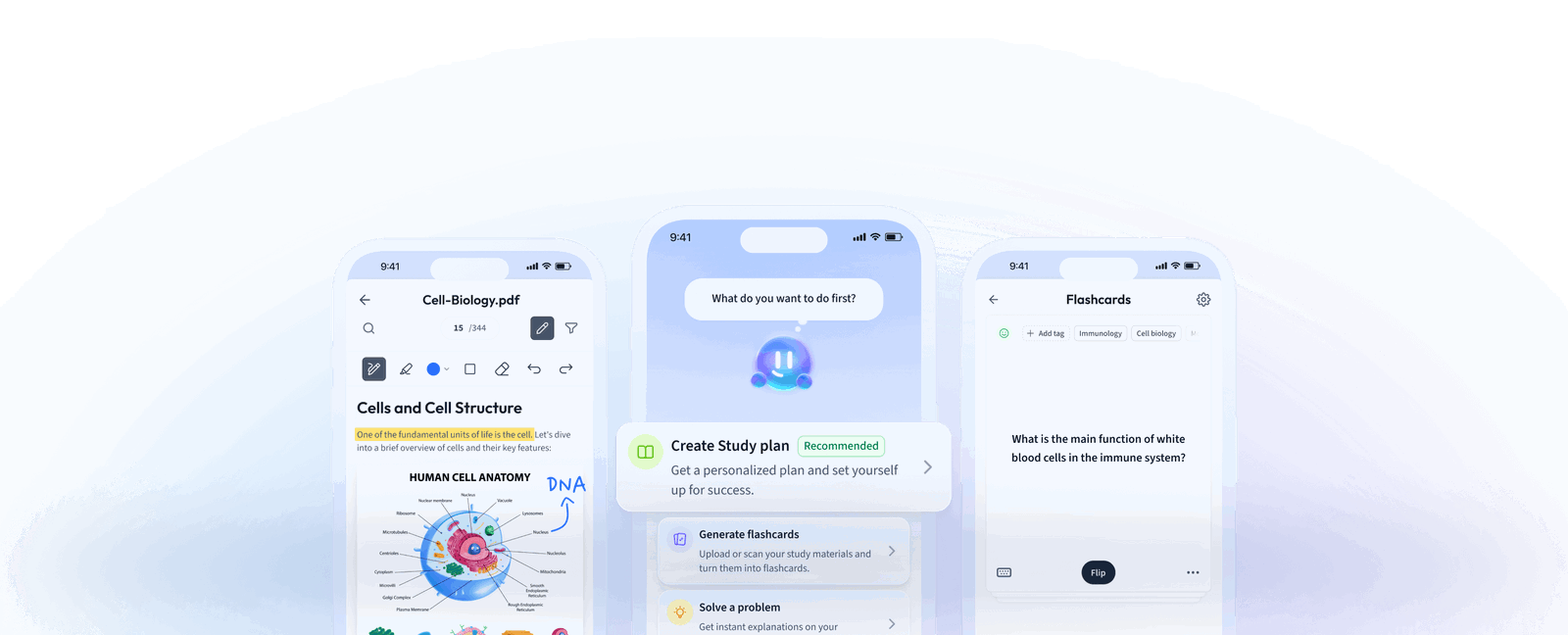

Lerne schneller mit den 12 Karteikarten zu Rechenkomplexität

Melde dich kostenlos an, um Zugriff auf all unsere Karteikarten zu erhalten.

Häufig gestellte Fragen zum Thema Rechenkomplexität

Über StudySmarter

StudySmarter ist ein weltweit anerkanntes Bildungstechnologie-Unternehmen, das eine ganzheitliche Lernplattform für Schüler und Studenten aller Altersstufen und Bildungsniveaus bietet. Unsere Plattform unterstützt das Lernen in einer breiten Palette von Fächern, einschließlich MINT, Sozialwissenschaften und Sprachen, und hilft den Schülern auch, weltweit verschiedene Tests und Prüfungen wie GCSE, A Level, SAT, ACT, Abitur und mehr erfolgreich zu meistern. Wir bieten eine umfangreiche Bibliothek von Lernmaterialien, einschließlich interaktiver Karteikarten, umfassender Lehrbuchlösungen und detaillierter Erklärungen. Die fortschrittliche Technologie und Werkzeuge, die wir zur Verfügung stellen, helfen Schülern, ihre eigenen Lernmaterialien zu erstellen. Die Inhalte von StudySmarter sind nicht nur von Experten geprüft, sondern werden auch regelmäßig aktualisiert, um Genauigkeit und Relevanz zu gewährleisten.

Erfahre mehr