Danke für dein Interesse an Audio-Lernen!

Die Funktion ist noch nicht ganz fertig, aber wir würden gerne wissen, warum du Audio-Lernen bevorzugst.

Warum bevorzugst du Audio-Lernen? (optional)

Feedback sendenWas ist Datenimport?

Datenimport bezieht sich auf den Prozess, bei dem Daten aus unterschiedlichen Quellen in ein Softwaresystem oder eine Datenbank geladen werden. Dieser Vorgang ist ein wesentlicher Bestandteil der Datenverwaltung in der IT.

Warum ist Datenimport wichtig?

- Datenintegration: Er ermöglicht die Integration von Daten aus verschiedenen Quellen.

- Automatisierung: Ein gut konzipierter Datenimport spart Zeit und reduziert Fehler durch Automatisierung.

- Aktualisierung: Durch den Datenimport werden Systeme stets mit den aktuellsten Informationen gespeist.

Wie funktioniert Datenimport?

Der Datenimportprozess umfasst mehrere Schritte, darunter das Extrahieren von Daten aus der Quelle, das Umwandeln der Daten in ein geeignetes Format und schließlich das Laden der Daten in das Zielsystem. Ein typisches Beispiel ist der Import von Kundendaten aus einer externen CSV-Datei in ein CRM-System.

CSV-Datei: Ein Dateiformat, das Daten als kommaseparierte Werte speichert. CSV steht für 'Comma-Separated Values'.

Beispiel für einen Datenimport in Python:

import pandas as pd data = pd.read_csv('kunden.csv') In diesem Beispiel wird die Bibliothek 'pandas' verwendet, um eine CSV-Datei zu importieren. Werkzeuge und Technologien für den Datenimport

Es gibt eine Vielzahl von Tools, die den Datenimport unterstützen, einige davon sind:

- Pandas: Eine Python-Bibliothek, die vor allem für die Datenanalyse genutzt wird.

- Apache Nifi: Bietet eine webbasierte Benutzeroberfläche zum Designen von Datenflüssen.

- Talend: Ein Tool für die Datenintegration, bekannt für seine Benutzerfreundlichkeit und Drag-and-Drop-Funktionalität.

Die Wahl des richtigen Tools hängt von den spezifischen Anforderungen und dem vorhandenen IT-Ökosystem ab.

Ein interessanter Aspekt des Datenimports ist die Datenqualität. Während des Importprozesses müssen Daten oft auf Konsistenz, Genauigkeit und Vollständigkeit geprüft werden. Daher ist es wichtig, vor dem Import eine robuste Validierung und Bereinigung der Daten durchzuführen, um sicherzustellen, dass die importierten Daten den Qualitätsanforderungen des Zielsystems entsprechen. Tools wie OpenRefine können zur Unterstützung der Datenbereinigung vor dem Import verwendet werden.

Datenimport einfach erklärt

Bevor Daten effektiv genutzt werden können, müssen sie oft aus verschiedenen Quellen bezogen und in ein zentrales System integriert werden. Der Prozess dafür heißt Datenimport.

Verfahren im Datenimport

Der Datenimport umfasst typischerweise die folgenden Schritte:

- Extraktion: Daten werden aus einer Quelle wie Datenbanken oder Dateien extrahiert.

- Transformation: Die Daten werden in das passende Format gebracht.

- Laden: Daten werden in das Zielsystem importiert.

Datenintegrität: Bezeichnet die Genauigkeit und Zuverlässigkeit von Daten im System.

Beispiel zur Verdeutlichung:

import pandas as pd data = pd.read_csv('datenquelle.csv') In diesem Python-Beispiel wird eine CSV-Datei importiert, um die Daten in einem DataFrame zu manipulieren. Anwendung gängiger Tools

Es gibt viele Tools, um den Datenimport zu erleichtern und zu verwalten. Diese Tools helfen auch bei der Bearbeitung und Integration großer Datenmengen:

| Tool | Funktion |

| Pandas | Ideal für die Datenanalyse und den Import in Python. |

| Apache Nifi | Webbasiert, zum Design von Datenflüssen geeignet. |

| Talend | Einfach und nutzerfreundlich für Datenintegration. |

Die Wahl des Tools richtet sich nach den spezifischen Anforderungen und der Struktur des vorhandenen Systems.

Ein tiefgehender Aspekt des Datenimports ist die Datensicherheit. Während des Importvorgangs ist es wichtig, Datenschutzmaßnahmen wie Verschlüsselung und Zugriffskontrollen zu implementieren, um die Daten vor unbefugtem Zugriff zu schützen. Außerdem sollte der Datenimportprozess regelmäßig überprüft werden, um Sicherheitslücken zu erkennen und zu beheben. Solide Sicherheitspraktiken sind entscheidend, um sicherzustellen, dass Daten während des gesamten Importprozesses sicher und geschützt bleiben.

Datenimport in Datenbanken

Datenimport in Datenbanken spielt eine entscheidende Rolle bei der Integration von Daten aus verschiedenen Quellen. Datenbanken bieten Strukturen, um große Mengen an Information effizient zu verwalten und zu abrufen.

Datenimport in SQL

Der SQL-Datenimport ermöglicht es, externe Daten in eine SQL-Datenbank zu integrieren. Hierbei wird die SQL-Sprache genutzt, um Datenextraktion und -manipulation durchzuführen. SQL ist besonders vorteilhaft für seine Fähigkeit, mit strukturierten Daten zu arbeiten, indem es präzise und schnelle Abfragen ermöglicht. Einige Möglichkeiten des Datenimports in SQL umfassen:

- Bulk Import: Ideal für große Datenmengen, um die Importzeit zu reduzieren.

- Data Migration Tools: Werkzeuge wie SQL Server Import and Export Wizard, die visuelle Unterstützung bieten.

Beispiel für einen einfachen SQL-Import:

BULK INSERT Datenbankname.Schema.Tabelle FROM 'pfad/zur/datei.csv' WITH (FIELDTERMINATOR = ',', ROWTERMINATOR = '');Dieses SQL-Skript zeigt, wie eine CSV-Datei mittels Bulk Import in eine SQL-Datenbank importiert wird.

Achte auf Dateiformate und Feldtrennzeichen, um Datenkorruption beim Import zu vermeiden.

Datenimport-Prozess

Der Prozess des Datenimports umfasst mehrere wesentliche Schritte, um sicherzustellen, dass Daten korrekt und vollständig in das Zielsystem importiert werden. Typische Schritte im Datenimport-Prozess sind:

- Datenmapping: Zuordnen der Quellfelder zu den Zielfeldern, um Konsistenz sicherzustellen.

- Datenbereinigung: Entfernen von Duplikaten und fehlerhaften Daten.

- Datenintegration: Zusammenführen von Daten aus verschiedenen Quellen in ein einheitliches System.

Datenmapping: Der Prozess der Verknüpfung von Datenfeldern zwischen zwei unterschiedlichen Datenmodellen.

Bei der Durchführung eines Datenimportprozesses ist die Validierung ein kritischer Schritt. Sie gewährleistet, dass die importierten Daten den Anforderungen der Zielanwendung entsprechen. Dazu werden Daten gegen vordefinierte Qualitätsstandards geprüft. Advanced Mapping-Technologien können bei der Validierung automatisiert helfen und stellen sicher, dass die Daten zufriedenstellend transformiert und integriert werden. Werkzeuge wie Talend oder IBM InfoSphere DataStage bieten umfassende Funktionen zur Unterstützung dieses Prozesses.

Datenimport-Techniken

Der Datenimport ist ein wesentlicher Prozess beim Übertragen von Daten aus externen Quellen in ein System. Verschiedene Techniken werden eingesetzt, um sicherzustellen, dass der Import effizient und fehlerfrei erfolgt. Hier sind einige der gängigen Methoden.

Manueller Datenimport

Der manuelle Datenimport erfolgt durch Benutzereingaben oder das Hochladen von Dateien über Benutzerschnittstellen. Dies ist üblich für kleinere Datenmengen oder einmalige Datenübertragungen. Vorteile des manuellen Imports sind:

- Einfach für kleine Datenmengen.

- Keine spezialisierte Software erforderlich.

Beispiel: Ein Buchhalter gibt monatlich Transaktionsdaten aus einem Excel-Dokument in eine Finanzsoftware ein.

Manuelle Importe sind anfällig für Fehler, da sie von menschlicher Eingabe abhängen.

Automatisierter Datenimport

Beim automatisierten Datenimport werden Daten ohne manuellen Eingriff übertragen. Diese Technik ist besonders vorteilhaft für größere Datenmengen oder regelmäßige Datenaktualisierungen. Automatisierungswerkzeuge können Scripting-Sprachen oder spezialisierte Softwarelösungen umfassen:

| Methode | Beispiel |

| Scripting | Python-Skripte zur Datenverarbeitung und -übertragung. |

| Softwarelösungen | Verwendung von ETL-Tools wie Apache Nifi oder Talend. |

ETL: Steht für Extract, Transform, Load - einen Prozess in der Datenverarbeitung.

Automatisierte Importe minimieren menschliche Fehler und steigern die Effizienz erheblich. Beim Einsatz von ETL-Tools wird zuerst der Extraktionsprozess angestoßen, bei dem die Daten aus verschiedenen Quellen gesammelt werden. Dies wird gefolgt von der Transformation, bei der Daten bereinigt und an die Anforderungen des Zielsystems angepasst werden. Zuletzt wird durch den Ladevorgang sichergestellt, dass die Daten sicher und vollständig importiert werden. Ein gut eingerichteter ETL-Prozess kann enorme Datenmengen in kurzer Zeit bewältigen und ist essenziell für datengetriebene Unternehmen.

Datenimport Beispiele

Datenimporte sind in verschiedenen Szenarien des täglichen IT-Betriebs von entscheidender Bedeutung. Sie ermöglichen es, Daten aus externen Quellen effizient in ein System zu integrieren, was für zügige Geschäftsprozesse unerlässlich ist. Hier werden einige praxisnahe Beispiele vorgestellt, die die Vielfalt der Anwendungen des Datenimports verdeutlichen.

Import von Kundendaten in ein CRM-System

Ein sehr verbreitetes Szenario ist der Import von Kundendaten in ein Customer Relationship Management (CRM) System. Dies ermöglicht es Unternehmen, alle Kundendaten an einem Ort zu verwalten und zu analysieren.

Beispiel für den CSV-Import in ein CRM:

import pandas as pd df = pd.read_csv('kunden.csv') print(df.head()) Dieses einfache Script zeigt, wie eine CSV-Datei in einen DataFrame geladen wird, der anschließend in das CRM-System importiert werden kann. Ein tieferer Einblick in den Kundendatenimport zeigt, dass neben dem reinen Import zusätzlich auch die Datenvalidierung eine große Rolle spielt. Es muss sichergestellt werden, dass die Daten korrekt und vollständig sind, um die CRM-Analysen nicht zu verfälschen. Algorithmen zur Überprüfung von Duplikaten und zur Korrektur von Datenfehlern werden oft in diesen Importprozess integriert.

Finanzdatenimport in Buchhaltungssoftware

Ein weiteres Beispiel ist der Import von Finanzdaten in eine Buchhaltungssoftware. Dieser Prozess erleichtert es Finanzabteilungen, korrekt und effizient mit Abrechnungen und Finanzberichten zu arbeiten.

Beispielcode für den Excel-Import in eine Buchhaltungssoftware:

import openpyxl workbook = openpyxl.load_workbook('finanzen.xlsx') sheet = workbook.active for row in sheet.iter_rows(): print(row[0].value, row[1].value) Hierbei wird die Bibliothek 'openpyxl' verwendet, um Excel-Daten in Python zu verarbeiten und schließlich in eine Buchhaltungssoftware zu importieren. Eine kontinuierliche Aktualisierung der Finanzdaten durch automatisierte Importe kann den Monatsabschluss erheblich beschleunigen.

Datenimport - Das Wichtigste

- Datenimport bezieht sich auf das Laden von Daten aus unterschiedlichen Quellen in ein Softwaresystem oder eine Datenbank.

- Ein gut geplanter Datenimportprozess umfasst Schritte wie Extraktion, Transformation und Laden der Daten.

- Für den Datenimport gibt es zahlreiche Tools, z.B. Pandas (Python-Bibliothek), Apache Nifi und Talend.

- Beim Datenimport in SQL können Techniken wie Bulk Import und Data Migration Tools wie der SQL Server Import and Export Wizard genutzt werden.

- Datenqualität und Datensicherheit sind entscheidende Aspekte im Datenimportprozess, es müssen Validierung und Datenschutzmaßnahmen implementiert werden.

- Datenimport Beispiele veranschaulichen die praktische Anwendung, etwa den Import von Kundendaten in ein CRM-System oder von Finanzdaten in eine Buchhaltungssoftware.

Lerne schneller mit den 10 Karteikarten zu Datenimport

Melde dich kostenlos an, um Zugriff auf all unsere Karteikarten zu erhalten.

Häufig gestellte Fragen zum Thema Datenimport

Über StudySmarter

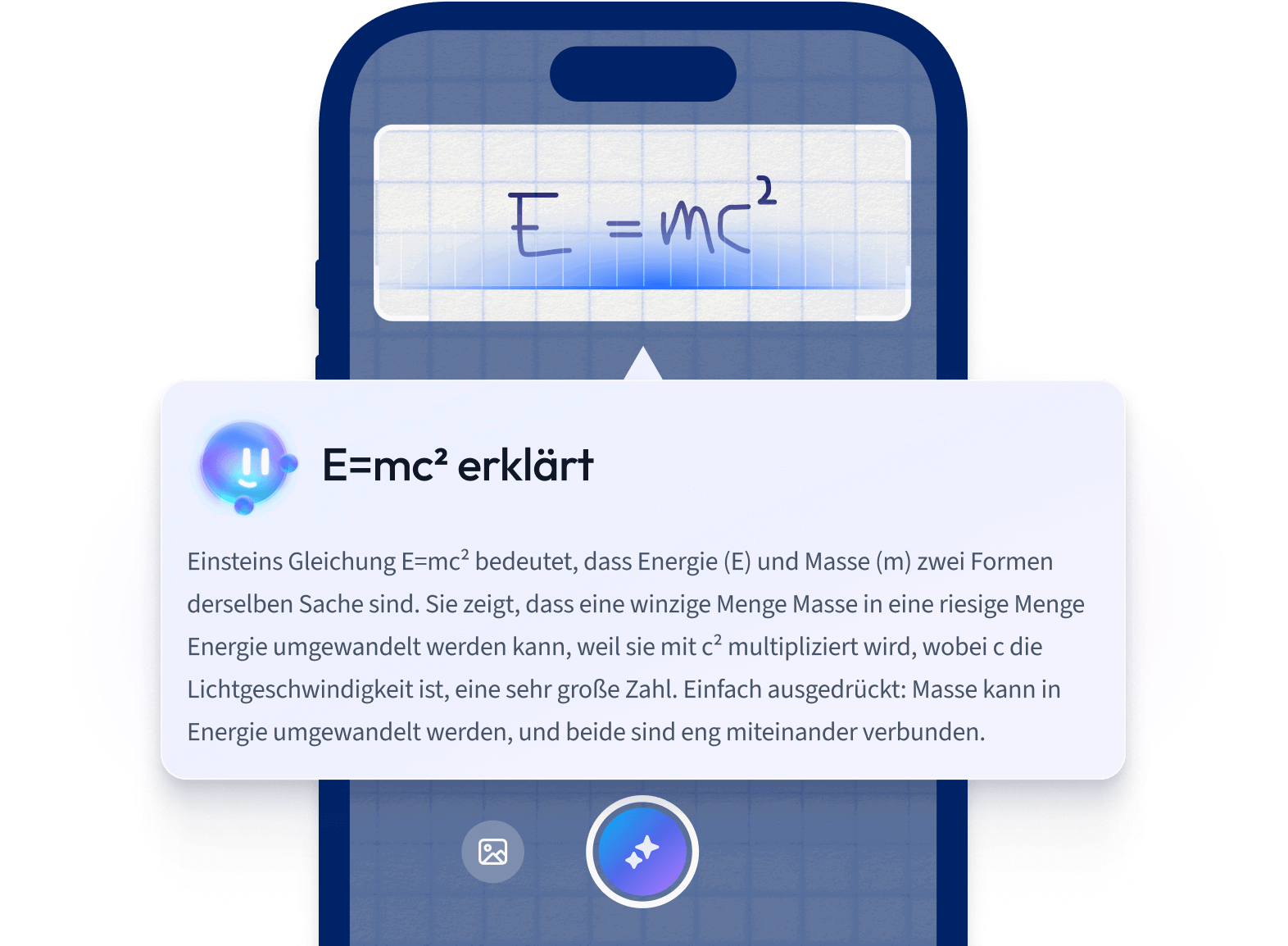

StudySmarter ist ein weltweit anerkanntes Bildungstechnologie-Unternehmen, das eine ganzheitliche Lernplattform für Schüler und Studenten aller Altersstufen und Bildungsniveaus bietet. Unsere Plattform unterstützt das Lernen in einer breiten Palette von Fächern, einschließlich MINT, Sozialwissenschaften und Sprachen, und hilft den Schülern auch, weltweit verschiedene Tests und Prüfungen wie GCSE, A Level, SAT, ACT, Abitur und mehr erfolgreich zu meistern. Wir bieten eine umfangreiche Bibliothek von Lernmaterialien, einschließlich interaktiver Karteikarten, umfassender Lehrbuchlösungen und detaillierter Erklärungen. Die fortschrittliche Technologie und Werkzeuge, die wir zur Verfügung stellen, helfen Schülern, ihre eigenen Lernmaterialien zu erstellen. Die Inhalte von StudySmarter sind nicht nur von Experten geprüft, sondern werden auch regelmäßig aktualisiert, um Genauigkeit und Relevanz zu gewährleisten.

Erfahre mehr