Was ist RMSProp Optimierer?

RMSProp ist ein beliebter Optimierungsalgorithmus, der in der Welt des maschinellen Lernens verwendet wird. Dieser Algorithmus hilft, die Konvergenz von Modellen zu beschleunigen, indem er das Lernverhalten anpasst.

RMSProp im Detail

Der RMSProp-Algorithmus wurde von Geoffrey Hinton entwickelt, um einige der Schwächen von vorherigen Optimierungsalgorithmen wie dem Adagrad zu überwinden. Der Hauptvorteil von RMSProp ist, dass er die Größe der Lernraten dynamisch basierend auf historischen Gradienteninformationen anpasst. Dies ermöglicht eine schnellere und stabilere Konvergenz.Der Algorithmus arbeitet, indem er den quadratischen gleitenden Mittelwert der Gradienten verfolgt. Dies geschieht nach der Formel:

RMSProp steht für Root Mean Square Propagation, einen Algorithmus zur Anpassung der Lernraten in neuronalen Netzen.

Angenommen, Du trainierst ein neuronales Netz auf einem MNIST-Datensatz. Du initialisierst RMSProp mit einer Lernrate von 0,001. Während des Trainings ermöglicht RMSProp Deinem Modell, seinen Lernschritt dynamisch zu verändern, was zur effektiven Konvergenz beiträgt, insbesondere in komplexen Architekturen.

RMSProp ist besonders effektiv, wenn Du auf stark verrauschten Daten trainierst.

Ein tieferes Verständnis von RMSProp hilft, seine Stärken zu schätzen. Traditionelle Gradient-Descent-Algorithmen leiden oft unter instabilen Updates, da sie allen Parametern die gleiche Lernrate zuweisen. RMSProp behandelt dies durch die Einführung einer spezifischen Lernrate für jede Dimension. Der Algorithmus berechnet den quadratischen gleitenden Mittelwert der Gradienten, was eine natürliche Form der Regularisierung schafft. Diese Regularisierung kann helfen, das Problem des Overshootings bei der Modellanpassung zu minimieren und das Risiko des Überanpassens zu senken. Insbesondere bei tiefen neuronalen Netzwerken bietet RMSProp eine sehr schnelle Konvergenzzeit und reduziert die Oszillation in der Loss-Funktion. Das kontinuierliche Anpassen der Lernraten macht den Algorithmus flexibel für verschiedene Datenstrukturen und erhöht die Wahrscheinlichkeit einer globalen Lösung anstelle von lokalem Minimum.

RMSProp Erklaerung fuer Anfaenger

RMSProp ist ein leistungsfähiger Algorithmus zur Optimierung des Trainingsprozesses von neuronalen Netzwerken. Er passt dynamisch die Lernrate auf Basis von zurückliegenden Gradienteninformationen an.

Grundlagen des RMSProp Verfahrens

Das RMSProp-Verfahren wurde entwickelt, um die Herausforderungen bei der Optimierung von neuronalen Netzen zu bewältigen. Es basiert auf der schrittweisen Anpassung der Lernraten, wodurch die Geschwindigkeit und Stabilität während des Trainings verbessert werden.Ein einfacher Weg, RMSProp zu verstehen, ist die Betrachtung seines Prinzips, den quadratischen gleitenden Mittelwert der Gradienten zu verwenden. Die Berechnung erfolgt nach der Formel:

RMSProp ist ein Optimierungsalgorithmus, der den gleitenden Mittelwert der Gradienten nutzt, um adaptiv die Lernrate anzupassen.

Ein typisches Beispiel für die Anwendung von RMSProp ist das Training eines tiefen neuronalen Netzwerks zur Bildklassifikation. Betrachte ein Szenario, in dem Du ein Modell erstellst, um handschriftliche Ziffern zu erkennen. Mit RMSProp passt sich die Lernrate automatisch an, um mit variierenden Daten und Bedingungen effektiv umzugehen, was zu einer besseren Leistungsfähigkeit des Modells führt.

RMSProp eignet sich besonders gut für tiefe neuronale Netze und Modelle, die auf unregelmäßigen oder verrauschten Daten trainiert werden.

Ein entscheidender Aspekt von RMSProp liegt in seiner Fähigkeit, die Optimierungseffizienz bei Modellen zu erhöhen, die viele Parameter und komplexe Strukturen aufweisen. Durch die Nutzung des gleitenden Mittelwerts der Gradientenquadrate überwindet RMSProp die Tendenz von Adagrad, die Lernrate zu stark abzuschwächen. Dies macht RMSProp besonders geeignet für Modelle, die eine variable Dynamik während des Trainings erfordern. Indem es das Problem der zu großen Lernratenminderung vermeidet, kann RMSProp bei langfristigen Optimierungsläufen stabil bleiben und die Neigung zur Konvergenz auf lokaler Minimum überwinden.In der Forschung wird RMSProp oft bevorzugt in Kombination mit anderen Techniken wie Batch-Normalisierung eingesetzt, um das Training tiefgreifender architektonischer Modelle zu stabilisieren und zu beschleunigen. Analysen zeigen, dass RMSProp nicht nur durch adaptive Lernraten, sondern auch durch seine inhärente Stabilisierung von Gradientenschwankungen signifikante Verbesserungen in der Modellleistung bietet.

RMSProp Schritt-für-Schritt Anleitung

RMSProp ist ein leistungsfähiger Optimierungsalgorithmus, der verwendet wird, um die Konvergenzgeschwindigkeit von Modellen beim maschinellen Lernen zu verbessern. Aufgrund seiner Fähigkeit, die Lernrate dynamisch anzupassen, wird RMSProp häufig in tiefen neuronalen Netzwerken eingesetzt.

RMSProp Formel und Berechnung

Um den RMSProp-Algorithmus besser zu verstehen, betrachten wir die Formel, die für die Berechnung verwendet wird. Der Algorithmus verfolgt den quadratischen gleitenden Mittelwert der Gradienten:

Die RMSProp Formel passt dynamisch die Lernraten basierend auf dem gleitenden Mittelwert der Gradientenquadrate an.

Ein Beispiel für die Anwendung von RMSProp ist das Training eines neuronalen Netzwerks auf einem Bilddatensatz. Während des Trainings werden die Lernraten automatisch angepasst, um eine Balance zwischen schneller Konvergenz und Stabilität zu erreichen. Dies ist besonders nützlich, wenn die Daten starke Rauschspektren enthalten.

Stelle sicher, dass Deine Lernrate am Anfang klein genug ist, um das beste aus RMSProp herauszuholen.

RMSProp wurde entwickelt, um einige der Schwächen traditioneller Algorithmen wie dem Adagrad zu beheben. Wo Adagrad dazu neigt, die Lernrate im Laufe der Zeit zu stark zu reduzieren, bleibt RMSProp durch die Verwendung eines gleitenden Mittelwerts stabiler, was zu einer besseren langfristigen Leistung führt. Diese Stabilisierung hilft besonders bei tiefen neuronalen Netzwerken, die häufig sowohl lokale als auch globale Muster in der Datenanalyse bewältigen müssen. Der Einsatz von RMSProp in Kombination mit Techniken wie der Batch-Normalisierung hat sich auch in der Praxis als wirkungsvoll erwiesen, um die Performanz der Lernalgorithmen bei der Modellierung komplexer Strukturen zu optimieren. Hierdurch verringert sich das Risiko des Überanpassens. Zusätzlich ermöglicht die adaptiv angepasste Lernrate eine zunehmende Robustheit gegenüber dem Rauschen in den Daten sowie eine verbesserte Konvergenzgeschwindigkeit.

Anwendung und Vorteile des RMSProp Optimierers

Der RMSProp Optimierer wird häufig in der technischen Wissenschaft und im maschinellen Lernen eingesetzt, um die Effektivität von Modelltrainings zu verbessern. Er eignet sich besonders gut für Probleme, bei denen die Daten unregelmäßig oder verrauscht sind.

Vorteile der RMSProp Anwendung

RMSProp bietet einige wichtige Vorteile, die ihn zu einer beliebten Wahl für das Optimieren neuronaler Netzwerke machen:

- Adaptive Lernrate: RMSProp passt die Lernrate automatisch für jeden Parameter an, basierend auf historischen Gradienteninformationen.

- Verbesserte Konvergenz: Durch die Nutzung des gleitenden Mittelwerts der Gradienten hilft RMSProp, die Konvergenzgeschwindigkeit zu erhöhen und Oszillationen während des Trainings zu verringern.

- Stabilität: RMSProp bietet in vielen Fällen eine stabilere Trainingsdynamik, insbesondere bei tiefen neuronalen Netzwerken, indem es die Lernrate individuell reguliert.

Der RMSProp Optimierer reguliert die Lernraten entsprechend historischen Gradientenwerten, was zu einer stabileren und schnelleren Konvergenz führt.

Stelle Dir vor, Du trainierst ein Modell zur Spracherkennung auf einem heterogenen Datensatz. Mit RMSProp werden die Lernraten automatisch angepasst, was zu einer verbesserten Stabilität und schnellerer Konvergenz führt, selbst wenn die Eingaben stark variieren.

Verwende RMSProp für Modelle mit hohem Rauschen in den Daten für stabilere Ergebnisse.

In einem tiefen Einblick in den RMSProp Optimierer offenbart sich seine Fähigkeit, die Probleme traditioneller Optimierer wie Adagrad zu umgehen, indem er die Lernrate nicht zu schnell reduziert. Durch die Verwendung einer gleitenden Durchschnittsformel für Gradientenquadrate:

RMSProp - Das Wichtigste

- RMSProp ist ein Algorithmus zur Optimierung von neuronalen Netzwerken, der die Lernrate auf Basis von zurückliegenden Gradienten dynamisch anpasst.

- Geoffrey Hinton entwickelte RMSProp, um Schwächen von Algorithmen wie Adagrad zu überwinden, indem es eine spezifische Lernrate für jede Dimension nutzt.

- Die Formel zur Berechnung des quadratischen gleitenden Mittelwerts der Gradienten in RMSProp ist:

- Die Parameteraktualisierung erfolgt über:

- RMSProp ist besonders effektiv für tiefe neuronale Netze und Daten mit hohem Rauschen, da es Stabilität und Schnelligkeit der Konvergenz fördert.

- In Kombination mit Techniken wie Batch-Normalisierung kann RMSProp die Performanz von Modellen bei der Datenanalyse und -optimierung erheblich verbessern.

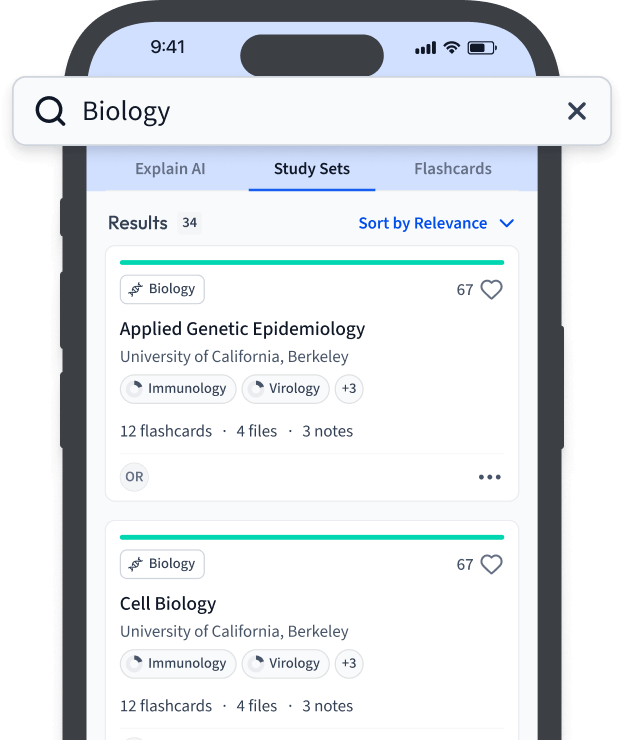

Lerne schneller mit den 12 Karteikarten zu RMSProp

Melde dich kostenlos an, um Zugriff auf all unsere Karteikarten zu erhalten.

Häufig gestellte Fragen zum Thema RMSProp

Über StudySmarter

StudySmarter ist ein weltweit anerkanntes Bildungstechnologie-Unternehmen, das eine ganzheitliche Lernplattform für Schüler und Studenten aller Altersstufen und Bildungsniveaus bietet. Unsere Plattform unterstützt das Lernen in einer breiten Palette von Fächern, einschließlich MINT, Sozialwissenschaften und Sprachen, und hilft den Schülern auch, weltweit verschiedene Tests und Prüfungen wie GCSE, A Level, SAT, ACT, Abitur und mehr erfolgreich zu meistern. Wir bieten eine umfangreiche Bibliothek von Lernmaterialien, einschließlich interaktiver Karteikarten, umfassender Lehrbuchlösungen und detaillierter Erklärungen. Die fortschrittliche Technologie und Werkzeuge, die wir zur Verfügung stellen, helfen Schülern, ihre eigenen Lernmaterialien zu erstellen. Die Inhalte von StudySmarter sind nicht nur von Experten geprüft, sondern werden auch regelmäßig aktualisiert, um Genauigkeit und Relevanz zu gewährleisten.

Erfahre mehr